Las inteligencias artificiales están viviendo sus días dorados. Cada día, hay nuevas herramientas que sorprenden a la vez que preocupan por el futuro de miles de trabajos. Pero también operan para fines nefarios. Se ha descubierto un nuevo modus operandi para estafadores: el uso de herramientas de inteligencia artificial que simulas las voces de otras personas, sobre todo, de nuestros familiares y amigos.

Así lo revela el caso de una pareja de Houston, quienes el mes pasado recibieron una llamada de su hijo, quien necesitaba $5,000 dólares para salir de un aprieto tras un accidente automovilístico. El problema es que, aunque fuera su voz, no era el hijo de la pareja, sino una herramienta de duplicación de voz que, con ayuda de un chatbot, clonó la voz del joven.

¿Pero cómo obtuvieron la voz del joven estos estafadores? De acuerdo con expertos en el tema, materiales como videos de Youtube, Tiktok o cualquier otro material audiovisual pueden ser suficiente para crear un patrón de voz.. Sólo se necesitan unos cuantos segundos, para que la clonación pueda llevarse a cabo.

Como en todos los casos, la recomendación sigue siendo la misma que con otras estafas similares, aunque menos sofisticadas: verificar que en realidad se trate de la persona en cuestión y, en caso de que no, colgar inmediatamente y denunciar el número antes la policía cibernética o las autoridades correspondientes.

eSports

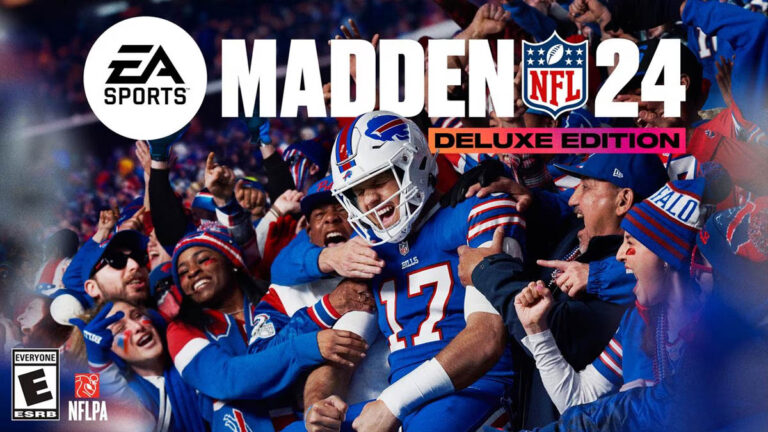

Madden 24 presenta tráiler y su portada de lujo con Josh Allen y los Bills de Buffalo

eSports

‘Diablo IV’ es el juego que más rápido se ha vendido en la historia de Blizzard